本文主要介绍Prometheus监控平台的部署搭建与使用,并在本地搭建Prometheus平台与各种exporter。

1. 监控的概念 为确保信息安全,及时发现任何潜在的问题并发出告警。比如某些应用停止响应,服务器发生故障或磁盘空间不足,则会提前通知,及时解决问题避免导致更严重的问题,我们在平时工作中需要监控平台帮助我们做到实时的问题发现、问题通知等操作,防患于未然。

而监控系统在监控时尽量对有意义的指标进行监控,而非无的放矢,一般业界可参考标准为:谷歌黄金标准(延迟、流量、错误、饱和度)、RED(每秒接受请求数、失败请求数、每个请求所花费的时长 适用于云原生及微服务)。

1.1 监控的模式 Pull模型:监控服务主动拉取被监控服务的指标被采集端无需感知监控系统的存在,完全独立于监控系统之外,这样数据的采集完全由监控系统控制,prometheus采用pull的模式获取监控数据。

Push模型:被监控服务主动将指标推送到监控服务。

这两种模型在业界都有使用,在使用时需要根据自己的业务场景进行选择没有必须纠结。

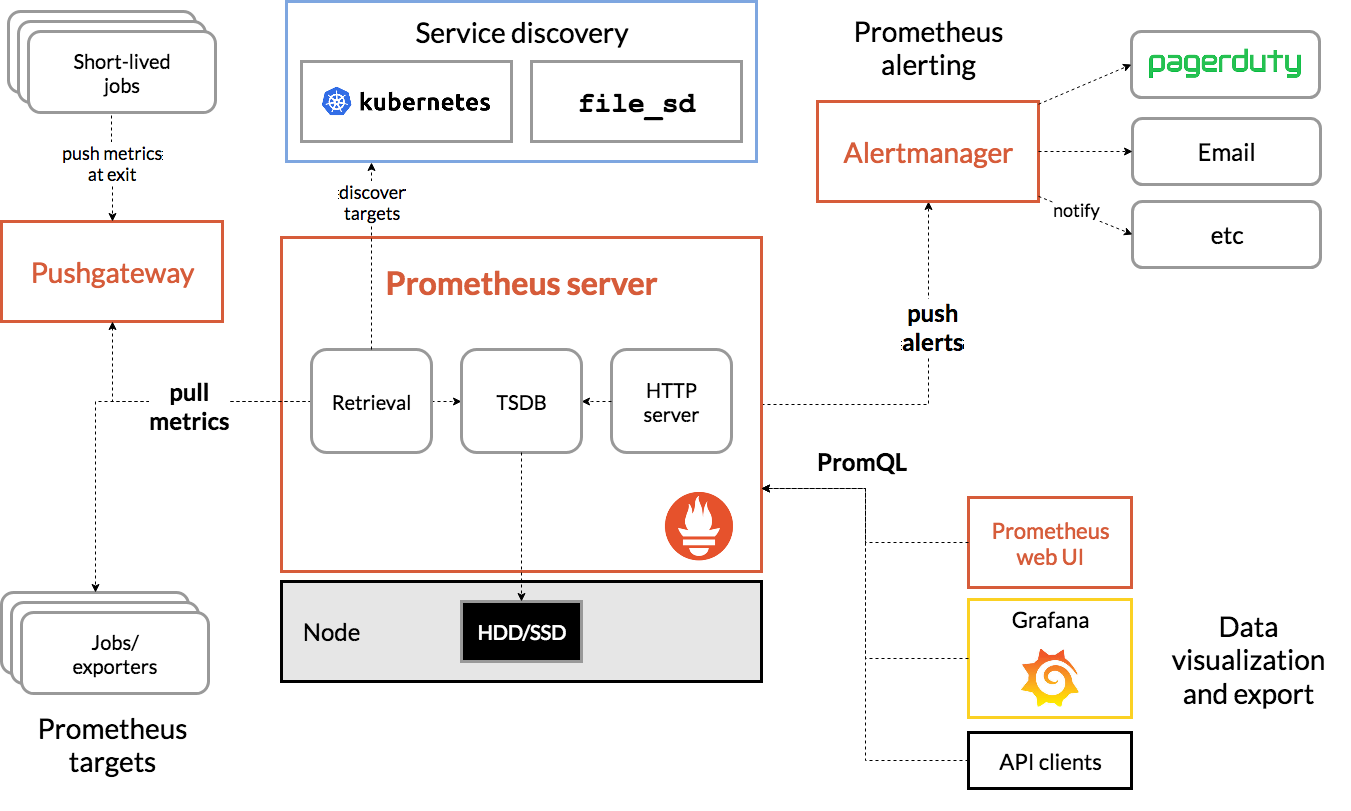

2. Prometheus介绍与安装 Prometheus作为业界主流的监控软件,其架构以Prometheus服务本身为中心,往下有各种各种exporter负责信息的采集,往上可以往alertManager推送告警信息,通过grafana进行进一步的图形展示,自身也将数据存储在本地与远端即可。

2.1 架构

Prometheus Server:prometheus组件中的核心部分,负责实现对监控数据的获取,存储以及查询

Exporters直接采集:直接内置了对Prometheus监控的支持,比如cAdvisor,Kubernetes,Etcd,Gokit`等

间接采集:原有监控目标并不直接支持Prometheus,因此我们需要通过Prometheus提供的Client Library编写该监控目标的监控采集程序。例如: Mysql Exporter,JMX Exporter,Consul Exporter等;

Alertanager AlertManager即Prometheus体系中的告警处理中心

PushGateway 当prometheus无法和exporter通信时,可以利用PushGateway来进行中转。PushGateway将内部网络的监控数 据主动Push到Gateway当中。而Prometheus Server则可以采用同样Pull的方式从PushGateway中获取到监控 数据

对于间接监控而言,在平时运维中针对某些地址端口联通性检测是经常使用到的,对于这种可通过安装一个blackbox_exporter,利用ping、http、tcp等方式去探测目标的情况来进行监控,但就无法获取到更详细的监控信息了,比如:cpu、内存等信息,如果资源是放在防火墙或者NAT之后的,可以用pushprox。

2.2 存储 Prometheus是由SoundCloud开发的开源监控报警系统和时序数据库(Time Series Database,TSDB),Storage通过一定的规则清理和整理数据,并把得到的结果从年初到新的时间序列 中,这里存储的方式有两种:

本地存储。通过Prometheus自带的时序数据库将数据库数据保存在本地磁盘。但 是本地存储的容量有限,默认保持15天

另一种是远程存储,适用于存储大量监控数据。通过中间层的适配器的转发,目前Prometheus支持OpenTsdb、InfluxDB、Elasticsearch等后端存储,通过适配器实现Prometheus存储的remote write和remote read接口,便可以接入Prometheus作为 远程存储使用。

2.3 安装 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 # 1. 下载地址 https://prometheus.io/download/ # 2. tar xvf prometheus-2.40.5.linux-arm64.tar.gz -C # 3. [root@a93fbab9aa5e prometheus]# pwd # 4. 配置启动文件 通过systemd的方式启动 # 5. 服务启动 # 通过浏览器http://172.17.0.2:9090即可访问

配置文件介绍:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 [root@xwhs prometheus ]global: scrape_interval: 15s evaluation_interval: 15s alerting: alertmanagers: - static_configs: - targets: rule_files: scrape_configs: - job_name: "prometheus" static_configs: - targets: ["localhost:9090" ]

一般在修改配置文件后,建议先检查配置,在重启服务:

1 2 3 [root@ylinyang prometheus]# ./promtool check config prometheus.yml

3. exporter 各种exporter的安装包都可以在官网 进行查找。

3.1 node_exporter 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 # 1. 下载解压 # 2. 没啥特殊就一个二进制文件 # 3. 配置启动文件

修改prometheus的启动配置文件,添加如上的exporter信息,修改如下:

1 2 3 4 5 6 7 8 9 10 11 # 添加如下三行 注意格式与对齐

3.2 mysqld_exporter 检测mysql的相关信息时,需要单独为mysqld_exporter创建一个账号,通过这个账号mysqld_exporter才能获取到相应的指标参数。

1 2 3 4 5 6 7 8 9 10 11 12 13 [root@xwhs ~]# yum install mariadb-server -y

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 # 在官网下载myqld_exporter,解压并配置配置密码文件,启动脚本

1 2 3 4 5 # 修改prometheus配置文件,添加mysqld_exporter的target,重启prometheus在查看

当我们需要查询某一项指标信息的时候,首先需要知道直接的查询语句,比如要查询mysql的慢查询信息,直接在mysql中查询为:show global status like 'slow%que%';而我们需要将其转化为promQL语句为mysql_global_status_slow_queries在prometheus中进行查询。

3.3 blackbox_exporter 通过安装blackbox_exporter检测不能安装exporter的机器中服务的存活性,如下探测114.114.114.114地址的是否存活。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 # 官网下载解压、安装、配置blackbox.yml文件 该文件记录了需要探测的信息 配置启动文件 # 配置blackbox.yml文件,添加如下几行配置参数 # 配置启动文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 - job_name: 'ping_all' scrape_interval: 1m metrics_path: /probe params: module: [icmp ] static_configs: - targets: - 114.114 .114 .114 labels: instance: gg relabel_configs: - source_labels: [__address__ ]target_label: __param_target - target_label: __address__ replacement: 127.0 .0 .1 :9115

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 - job_name: 'baidu_http' scrape_interval: 1m metrics_path: /probe params: module: [http_2xx ]static_configs: - targets: - www.baidu.com labels: instance: baidu relabel_configs: - source_labels: [__address__ ]target_label: __param_target - target_label: __address__ replacement: 127.0 .0 .1 :9115

其他第三方exporter可在官网 进行查询

3.4 telegraf 在检查某些资源时也可以不安装对应的exporter,可以安装telegraf在这个包中,集成了很多服务的监控文件,一个即可检测多个服务情况。

1 2 3 4 5 6 7 8 9 10 # 1. 下载地址 https://github.com/influxdata/telegraf/tags # 2. 监控各种资源的配置文档 https://github.com/influxdata/telegraf/tree/master/plugins/inputs # 3. 下载安装 # 4. 配置文件 # 5. 在prometheus中添加job时 端口为telegraf资源配置文件中定义的端口

4. 服务发现 当每次有新的资源指标需要添加时,都需要重新修改配置文件比较麻烦,可以通过服务发现的方式进行自动配置

4.1 基于文件的服务发现 1 2 3 4 5 6 7 8 9 10 11 # 重新修改prometheus配置文件,如下 # 编辑文件 这个文件可以手动编写 也可以自动生成

4.2 基于consul的服务发现 安装consul服务,这个服务将信息注册到consul里面,prometheus监控从consul里面获取各服务指标信息。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 # 1. 安装consul 下载地址 https://releases.hashicorp.com/consul # 2. 配置启动文件 注意文件和数据目录 journalctl -xe |grep consul 排查命令 # 3. http://192.168.0.115:8500 登录 # 4. 修改prometheus文件 添加consul 这里services下匹配的name,不是id # 可以参考该文章 https://blog.csdn.net/aixiaoyang168/article/details/103022342#3Consul__17

1 2 3 4 5 6 # consul的基本操作 # 注册服务 # 删除服务 最后跟的是id 不是名字

4.3 基于k8s的服务发现 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 - job_name: 'kubernetes-apiservers-monitor' kubernetes_sd_configs: - role: endpoints api_server: https://192.168.26.100:6443 tls_config: insecure_skip_verify: true bearer_token_file: /apps/prometheus/k8s.token scheme: https tls_config: insecure_skip_verify: true bearer_token_file: /apps/prometheus/k8s.token relabel_configs: - source_labels: [__meta_kubernetes_namespace , __meta_kubernetes_service_name , __meta_kubernetes_endpoint_port_name ]action: keep regex: default;kubernetes;http

4.4 基于dns的服务发现 基于dns的服务发现,需要在环境中配置一个dns服务器,并且将prometheus的dns修改,通过dns的SRV于A记录进行服务发现。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 # 1. 配置dns服务器

在各种服务发现中,最常用的就是文件发现和consul发现:

文件发现:可以配置一个cmdb平台,统一收集IP地址,通过脚本或者接口的方式,自动生成对应的yml文件

consul:通过脚本的方式注册到consul平台,confd+consul_template自动渲染prometheus配置文件